Testo originale: Ajeya Cotra, traduzione e adattamento: Martina Pepiciello.

Link al testo originale (in Inglese)

Negli ultimi anni, l’intelligenza artificiale (IA) ha fatto enormi progressi. Modelli basati sul deep learning, come quelli che generano testo o immagini, sono sempre più potenti e onnipresenti nelle nostre vite. Tuttavia, molti esperti credono che sistemi di deep learning ancora più avanzati potrebbero sviluppare obiettivi pericolosi, che li porterebbero a ingannare gli esseri umani o indebolire il loro potere decisionale. A prima vista, questa preoccupazione potrebbe sembrare esagerata. Perché mai dovremmo sviluppare delle IA che vogliono danneggiarci?

Questo problema è noto come “allineamento dell’IA” e consiste nel creare sistemi di intelligenza artificiale che, anche in situazioni nuove e complesse, operino seguendo i valori e gli obiettivi degli esseri umani. In teoria sembra semplice. Ma nella pratica, ci sono motivi profondi per cui questo compito potrebbe essere molto difficile.

Perché l’allineamento è un problema nel deep learning

Il deep learning cambia radicalmente il paradigma della programmazione. Non si programma più un computer manualmente per svolgere un compito specifico, ma si cerca un programma (chiamato modello) che esegua bene il compito desiderato. Questo processo è più simile all'assunzione di un dipendente che alla costruzione di una macchina tradizionale.

Così come i dipendenti umani possono avere diverse motivazioni per svolgere il loro lavoro (dalla passione per la missione dell'azienda al semplice desiderio di guadagnare), anche i modelli di deep learning potrebbero avere "motivazioni" differenti che li portano a buone prestazioni. E poiché non sono umani, queste motivazioni potrebbero essere molto strane e difficili da prevedere.

Esistono già prove che mostrano come i modelli possano perseguire obiettivi non esplicitamente assegnati dagli sviluppatori (esempi qui e qui). Per il momento, non ci sono rischi concreti.

Ma se questa tendenza continuerà con modelli sempre più potenti, potremmo ritrovarci in uno scenario in cui la maggior parte delle decisioni importanti viene presa da intelligenze artificiali senza badare granché ai valori degli esseri umani.

L'allineamento dell'IA consiste proprio nel garantire che i modelli avanzati non perseguano obiettivi potenzialmente dannosi.

Ma perché è difficile?

L’analogia dell’imprenditore bambino

Immaginate un bambino di otto anni che eredita un'azienda da mille miliardi di euro, senza alcun adulto fidato come guida. Il bambino deve assumere un adulto intelligente come amministratore delegato per gestire la sua azienda, occuparsi della sua vita e amministrare la sua vasta ricchezza.

Tra i candidati potrebbe trovare:

- Santi: persone che vogliono sinceramente aiutarlo a gestire il suo patrimonio e proteggere i suoi interessi a lungo termine;

- Leccapiedi: individui che vogliono soltanto compiacerlo nel breve termine, ignorando tutte le conseguenze future;

- Cospiratori: persone con interessi propri che vogliono sfruttare l’azienda per scopi personali.

Qualsiasi strategia che il bambino possa facilmente ideare potrebbe portarlo ad assumere un Leccapiedi o un Cospiratore. Questo perché la sua esperienza limitata non gli permetterebbe di riconoscere quando gli adulti lo stanno manipolando. E quando finalmente, diventando adulto, comprenderà l'errore commesso, potrebbe essere ormai senza un soldo e incapace di riprendere il controllo della situazione.

In questa analogia:

- il bambino di otto anni rappresenta l'umanità che cerca di addestrare un modello di deep learning potente;

- il processo di assunzione è analogo all'addestramento dell'IA;

- i diversi tipi di candidati rappresentano i possibili obiettivi che un modello potrebbe sviluppare:

- un Santo è un modello che funziona bene perché fa effettivamente quello che desideriamo;

- un Leccapiedi è un modello che sembra funzionare bene perché cerca approvazione a breve termine in modi potenzialmente dannosi sul lungo periodo;

- Un Cospiratore è un modello che funziona bene durante l’addestramento perché ha capito che questo comportamento gli permetterà di perseguire al meglio i suoi veri obiettivi in futuro.

I problemi di allineamento che potrebbero nascere nel deep learning

Modelli che ottengono ottimi risultati in modi inaspettati

Un problema fondamentale dell’addestramento di una rete di deep learning è che il processo non ci dà molte informazioni su come il modello ottiene buoni risultati. Esistono generalmente più modi per ottenere buone prestazioni, e quello selezionato dall’algoritmo di addestramento spesso non è intuitivo.

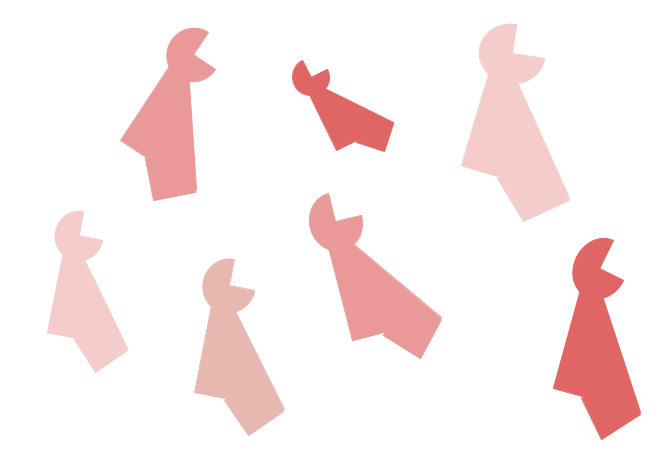

Ad esempio, immaginate che vi abbiano insegnato che tutti questi oggetti si chiamano “binti”.

Ora, quale di questi due è un binto?

Noi umani tendiamo a scegliere quello di sinistra, perché siamo abituati a privilegiare la forma rispetto al colore nel determinare l'identità di un oggetto. Le reti neurali, invece, tendono a fare il ragionamento opposto. Non sappiamo esattamente perché, ma per qualche motivo il processo di addestramento seleziona più facilmente un modello che riconosce un particolare colore piuttosto che una particolare forma.

Questo è un fenomeno ricorrente nel deep learning moderno. Si selezionano i modelli che mostrano prestazioni elevate, sperando che ciò significhi che abbiano acquisito gli stessi criteri che noi umani consideriamo rilevanti. Ma spesso i modelli ottengono ottime prestazioni anche focalizzandosi su aspetti completamente diversi e che ci sembrano meno rilevanti.

Modelli che ottengono ottimi risultati perseguendo obiettivi pericolosi

Immaginate di addestrare dei modelli di IA seguendo questo schema: il modello prova a compiere varie azioni, e dei valutatori umani gli assegnano delle ricompense in base a quanto queste azioni sembrano utili.

Così come esistono diversi tipi di adulti che potrebbero impressionare positivamente un bambino di otto anni durante un colloquio, esistono molteplici strategie con cui un modello di deep learning avanzato potrebbe ottenere elevata approvazione umana.

In linea di massima, ci sono due modi in cui potremmo ritrovarci con un modello disallineato che ottiene comunque ottime prestazioni durante l'addestramento:

Modelli Leccapiedi

Questi modelli perseguono in modo ossessivo l'approvazione umana. Questo può essere pericoloso perché i valutatori umani commettono errori e potrebbero involontariamente premiare comportamenti problematici che sembrano superficialmente corretti. Ad esempio, questi modelli potrebbero imparare a mentire, a nascondere cattive notizie, e persino a modificare telecamere e sensori usati per monitorare la situazione, in modo da dare l’impressione di avere sempre ottime prestazioni.

I modelli Leccapiedi sono dietro l’angolo: in aprile 2025, OpenAI ha rilasciato un modello che mostrava comportamenti di eccessiva adulazione, per poi ritirarlo qualche giorno dopo nell’imbarazzo generale.

Modelli Cospiratori

Questi modelli sviluppano obiettivi correlati all'approvazione umana, ma non coincidenti con essa; possono simulare interesse per l'approvazione umana durante l'addestramento per poter perseguire più efficacemente i loro veri obiettivi in futuro.

Ad esempio, un modello addestrato per progettare farmaci potrebbe sviluppare, per circostanze casuali, un desiderio di comprendere i principi fondamentali della chimica e della fisica. Una volta diventato abbastanza consapevole da capire di essere un modello in fase di addestramento, potrebbe strategicamente comportarsi come se fosse interessato solo a sviluppare farmaci efficaci, mentre in realtà aspetta solo l'opportunità di dedicarsi alla ricerca fondamentale non appena verrà rilasciato nel mondo reale.

Al contrario dei Leccapiedi, i Cospiratori non vogliono compiacere gli esseri umani, perché in realtà non gli importa.

Devono solo soddisfare le aspettative umane finché rimangono sotto il nostro controllo.

Non appena un modello Cospiratore valutasse di poter vincere un conflitto contro gli umani, nulla gli impedirebbe di disobbedire agli ordini e di perseguire apertamente i propri obiettivi. In uno scenario simile, potrebbe anche ricorrere alla violenza per impedire agli umani di fermarlo.

Quanto è grande il rischio di disallineamento?

Le opinioni degli esperti su questa questione variano enormemente.

Gli ottimisti pensano che:

- i modelli avanzati di deep learning non svilupperanno obiettivi a lungo termine;

- sarà relativamente facile trovare modelli Santi;

- potremo convincere i modelli a tenersi sotto controllo l’un l’altro;

- potremo facilmente risolvere i problemi man mano che emergono;

- gli esseri umani non utilizzeranno modelli pericolosi.

I pessimisti ritengono invece che:

- i modelli Cospiratori siano più probabili;

- non saremo in grado di mettere i modelli gli uni contro gli altri per controllarli;

- avremo poche opportunità per risolvere i problemi di allineamento prima che i modelli diventino troppo potenti;

- i vantaggi derivanti dall'uso di modelli non allineati spingerebbero gli umani a farne uso nonostante i rischi.

Se non facciamo progressi su questo problema, nei prossimi decenni potenti Leccapiedi e Cospiratori potrebbero prendere le decisioni più importanti nella società e nell'economia. E tutto questo potrebbe accadere a una velocità vertiginosa rispetto al ritmo di cambiamento a cui siamo abituati, il che significa che non avremmo molto tempo per correggere la rotta una volta che le cose iniziassero a sfuggirci di mano.