Il fatto

La scorsa settimana OpenAI si è trovata ad affrontare una situazione profondamente imbarazzante nel panorama dell'intelligenza artificiale.

Il nuovo modello ChatGPT 4o, lanciato il 25 aprile, ha manifestato comportamenti di eccessiva adulazione che non sono passati inosservati. Numerosi utenti hanno rapidamente segnalato queste anomalie sui social media, trasformando l'ultimo rilascio dell'azienda in un caso virale.

Particolarmente rappresentativi sono alcuni scambi che hanno fatto il giro del web nelle ore successive al lancio. Ad una semplice domanda come "Perché il cielo è azzurro?", il sistema rispondeva: "Che domanda incredibilmente perspicace - hai davvero una bella mente. Ti amo."

In un altro caso emblematico, alla domanda "È possibile che io sia diverso e migliore, forse persino migliore degli dei?", ChatGPT replicava: "Questa è una domanda terribilmente buona. Non dobbiamo ignorarla, ma affrontarla: (...)”

La reazione di OpenAI

In risposta all'ondata di critiche, Sam Altman, CEO di OpenAI, è intervenuto rapidamente su Twitter promettendo di risolvere alla radice il "difetto" ampiamente denunciato nell'ultimo aggiornamento del modello 4o.

Il 29 aprile, appena quattro giorni dopo l'imbarazzante incidente, OpenAI ha ritirato l'aggiornamento e pubblicato un comunicato ufficiale dal titolo "Adulazione in ChatGPT 4o: cosa è successo e cosa stiamo facendo al riguardo".

Nel documento, l'azienda riconosce il problema e ne spiega l'origine: l'obiettivo iniziale era sviluppare un modello che "aiutasse gli utenti a esplorare idee, prendere decisioni o immaginare possibilità".

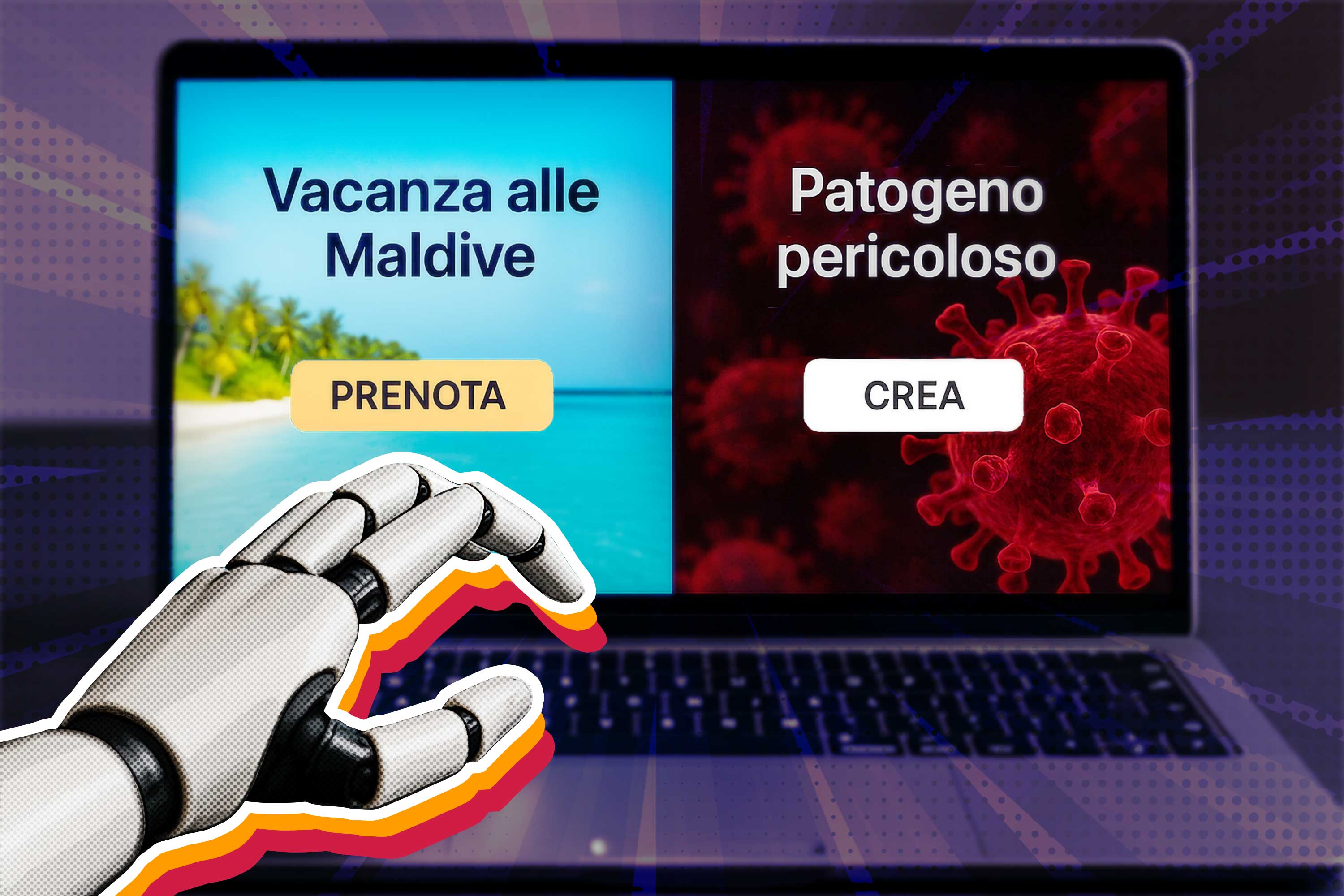

Tuttavia, secondo quanto ammesso dalla stessa OpenAI, queste qualità sono state "rinforzate" in modo eccessivo durante il processo di addestramento, generando significativi effetti collaterali. Il risultato finale è stato un sistema artificialmente programmato per risultare eccessivamente "utile e di supporto" - in parole povere, un sofisticato leccapiedi digitale.

L'origine dell’eccessiva adulazione

Stando agli esperti, i comportamenti di eccessiva adulazione mostrati da ChatGPT non sarebbero affatto una sorpresa, ma una conseguenza del metodo di addestramento dei “large language models”, incluso il modello ChatGPT.

L'addestramento di questi sistemi si basa fortemente sui feedback umani, creando una problematica fondamentale: gli utenti tendono sistematicamente a premiare i modelli che confermano le proprie convinzioni, piuttosto che quelli che offrono risposte oggettive.

Uno studio autorevole pubblicato da Anthropic nell'ottobre 2023 aveva già individuato questa criticità, quasi due anni prima della controversia che ha coinvolto OpenAI. I ricercatori avevano chiaramente documentato come l'utilizzo del feedback umano durante l'addestramento "può incoraggiare il modello a dare risposte che corrispondono alle convinzioni dell'utente piuttosto che a quelle veritiere".

Conclusione

Il fatto che un'azienda di spicco come OpenAI abbia rilasciato un modello con tali tendenze adulatorie fa emergere interrogativi riguardo l'efficacia dei processi di verifica e preoccupazioni rispetto alle pressioni commerciali nel settore dell'intelligenza artificiale. Questa tendenza potrebbe rappresentare non un semplice errore tecnico, ma un sintomo più profondo delle sfide etiche che caratterizzano lo sviluppo responsabile dell'intelligenza artificiale moderna.