In due parole

Oltre 100 esperti globali di intelligenza artificiale (IA) si sono riuniti a Singapore per delineare le priorità per lo sviluppo sicuro dell’IA. È stato stilato un documento che mira a guidare gli sforzi globali, superando le divisioni e favorendo un ecosistema digitale affidabile.

L'incontro che delinea le priorità della sicurezza dell'IA

Con l’intelligenza artificiale in rapida evoluzione, cresce anche l’urgenza di affrontarne i rischi. Ad aprile 2025, oltre 100 esperti di IA, scienziati, rappresentanti governativi e aziende si sono riuniti a Singapore per definire le priorità della ricerca globale sulla sicurezza dell’intelligenza artificiale. L'incontro, chiamato “Singapore Conference on AI: International Scientific Exchange on IA Safety”, ha portato alla pubblicazione di un documento chiave: il Consenso di Singapore sulle priorità globali della ricerca sulla sicurezza dell’IA.

Questo documento, basato sull’International AI Safety Report diretto da Yoshua Bengio e supportato da 33 governi, identifica tre aree principali su cui concentrare gli sforzi di ricerca per garantire che l’IA rimanga sotto controllo umano, affidabile e vantaggiosa per la società.

Il Consenso è il risultato di un ampio processo collaborativo. Il comitato scientifico include figure di spicco come Yoshua Bengio (MILA), Max Tegmark (MIT e Future of Life Institute) e Stuart Russell (UC Berkeley). I partecipanti che hanno contribuito al testo provengono da università, aziende come OpenAI e Google DeepMind, governi e organizzazioni civili.

Le tre priorità della sicurezza dell’IA: valutare, sviluppare, controllare

Il Consenso di Singapore raggruppa le priorità della sicurezza dell’IA in tre aree principali:

1. Valutazione del rischio: capire i pericoli dell’IA

Questa area riguarda lo studio e la misurazione dei potenziali rischi dei sistemi di IA, attuali e futuri. La ricerca mira a sviluppare metodi per misurare l'impatto dei sistemi di IA, infrastrutture di test sicure e analisi predittive. L’area include anche tentativi di quantificare la probabilità che un’IA avanzata sfugga al controllo umano.

2. Sviluppo sicuro: costruire IA affidabili fin dall’inizio

Qui l’obiettivo è progettare sistemi allineati ai valori e agli obiettivi umani. Si studiano metodi per evitare effetti collaterali indesiderati, resistere a manipolazioni, promuovere la “sincerità” delle IA, e prevenire capacità rischiose come un’eccessiva autonomia. Fondamentali sono anche gli strumenti di verifica e interpretabilità, per capire come un sistema prende decisioni.

3. Controllo post-distribuzione: gestire i sistemi in azione

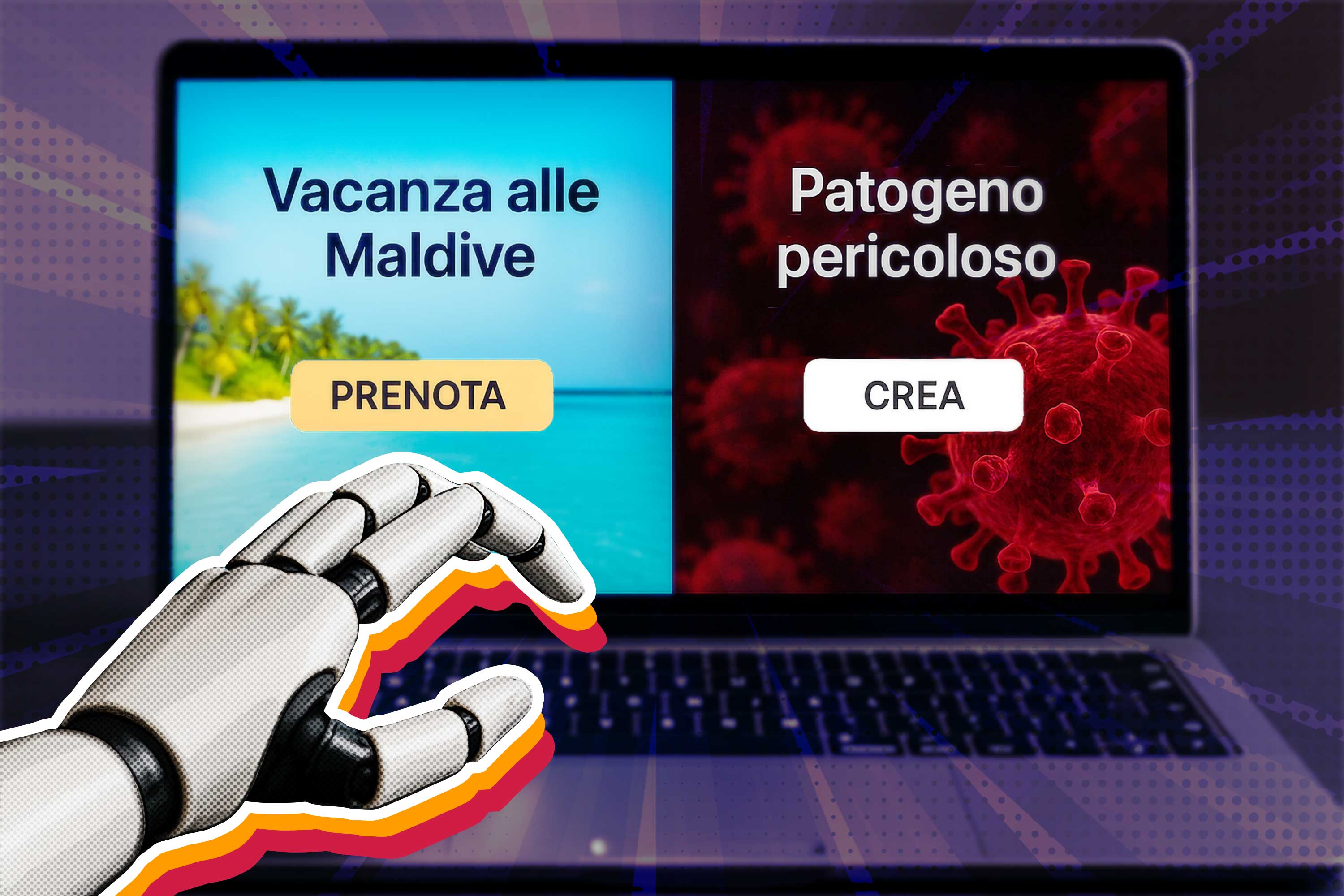

Una volta che un’IA è stata distribuita e attivata, servono meccanismi per monitorarne il comportamento, intervenire in caso di anomalie e garantire la sicurezza dell’ecosistema complessivo. La ricerca esplora strumenti di tracciamento, tecniche per fermare o correggere IA fuori controllo, e strategie per rafforzare la resilienza della società contro usi malevoli o incidenti tecnologici.

Un punto di svolta per la governance dell’IA

L’incontro a Singapore ha rappresentato un momento di svolta dopo il vertice di Parigi di febbraio 2025, che molti esperti hanno criticato per l’attenzione quasi esclusiva sui vantaggi economici dell’IA. A Singapore, invece, l’attenzione è stata sulla sicurezza tecnica e sulla cooperazione internazionale. Max Tegmark, co-organizzatore della conferenza, ha descritto l’atmosfera come “esattamente l’opposto di Parigi”, sottolineando il ritorno di uno spirito costruttivo tra scienziati e decisori politici.

La ministra singaporiana Josephine Teo ha evidenziato il valore di un dialogo diretto tra esperti e governi, necessario per costruire regole condivise e solide. Singapore, già attiva nella governance dell’innovazione digitale, rafforza così il suo ruolo centrale nella promozione di un'IA sicura e trasparente.

Verso una politica globale dell’IA

Il Consenso di Singapore verrà presentato ai ministri digitali durante l’Asia Tech x Singapore Summit di maggio. L’obiettivo è fornire una base tecnica solida per scelte politiche che bilancino innovazione e sicurezza.

Il documento è pensato come uno strumento concreto per facilitare la cooperazione tra paesi, aziende e scienziati, superando logiche di competizione in aree dove la collaborazione è vantaggiosa per tutti. Come sottolineato da Bengio, c’è una “convergenza globale sulle sfide tecniche nella sicurezza dell’IA” che unisce persino Stati Uniti e Cina.