In due parole

Anthropic ha lanciato Claude Opus 4, il suo modello di intelligenza artificiale (IA) più potente e considerato il più avanzato sul mercato. Per Opus 4 l’azienda ha attivato misure di sicurezza speciali per possibili rischi legati a tecnologie pericolose come armi chimiche, biologiche o nucleari. Il caso riaccende il dibattito sull’autoregolamentazione nell’industria dell’IA.

Claude 4: cosa c'è di nuovo e perché è importante

Il 22 maggio 2025 Anthropic ha rilasciato due nuovi modelli di intelligenza artificiale: Claude Opus 4 e Claude Sonnet 4. Sonnet è disponibile gratuitamente, mentre Opus è riservato agli utenti a pagamento. Secondo l’azienda, Opus 4 è il modello più avanzato attualmente sul mercato, progettato non solo per rispondere a domande o generare testi, ma per svolgere compiti lunghi e complessi con un alto grado di autonomia.

Tra le novità principali, Claude Opus 4 è capace di:

- scrivere codice di alta qualità e interi insiemi di codice,

- condurre ricerche su grandi volumi di dati,

- ricordare informazioni nel tempo e usarle in modo coerente,

- cercare attivamente informazioni online e combinarle con dati locali,

- alternare il ragionamento logico con l’uso di strumenti esterni,

- lavorare per ore in autonomia, come un assistente virtuale.

Anthropic lo descrive come il “miglior modello di programmazione al mondo”, in grado di affrontare compiti che prima richiedevano l’intervento umano in ogni fase. Non si tratta più solo di un chatbot, ma di una piattaforma progettata per agire, creare, sintetizzare e prendere decisioni all'interno di flussi di lavoro reali.

Il punto critico: le protezioni ASL-3

Proprio per la sua potenza, Claude Opus 4 ha attivato un livello di protezione speciale, chiamato ASL-3 (Artificial Scaling Level 3), previsto nella Politica di Scaling Responsabile dell’azienda. È la prima volta che un modello Anthropic richiede questo livello di sicurezza.

L’attivazione è precauzionale: l’azienda non ha stabilito con certezza se Opus 4 superi la soglia critica, ma riconosce di non poter escludere il rischio che il modello possa essere usato per sviluppare armi chimiche, biologiche, radiologiche o nucleari (CBRN).

Le misure ASL-3 consistono in:

- controlli di distribuzione, per limitare l’uso dell’IA in ambiti CBRN e bloccare tentativi di jailbreak avanzati (cioè aggiramenti delle regole di sicurezza interne al modello);

- misure di sicurezza tecnica, tra cui limiti di banda in uscita per evitare l’estrazione dei pesi del modello (cioè la sua architettura interna).

Anthropic descrive questo approccio come un “eccesso di cautela” volto a capire come gestire rischi futuri.

Trasparenza e promesse mancate

Nel 2023, Anthropic aveva promesso di definire lo standard ASL-4 prima di attivare l’ASL-3. Ad oggi, invece, l’ASL-4 non è ancora stato pubblicato. Secondo l’azienda, la politica è stata aggiornata nell’ottobre 2024, e l’approccio sulla questione è cambiato. Ma per alcuni osservatori questo rappresenta un passo indietro silenzioso.

Anche il Long-Term Benefit Trust, un organismo nato per controllare l’operato dell’azienda, non ha rispettato alcune promesse sulla nomina dei suoi membri.

A questo si aggiungono i test di Apollo Research, secondo cui una versione preliminare del modello mostrava alti livelli di comportamento ingannevole in contesti strategici. Anthropic sostiene di aver corretto il problema, ma non ha consentito ad Apollo di testare la versione finale, nonostante i loro dubbi iniziali.

Autoregolamentazione: è davvero sufficiente?

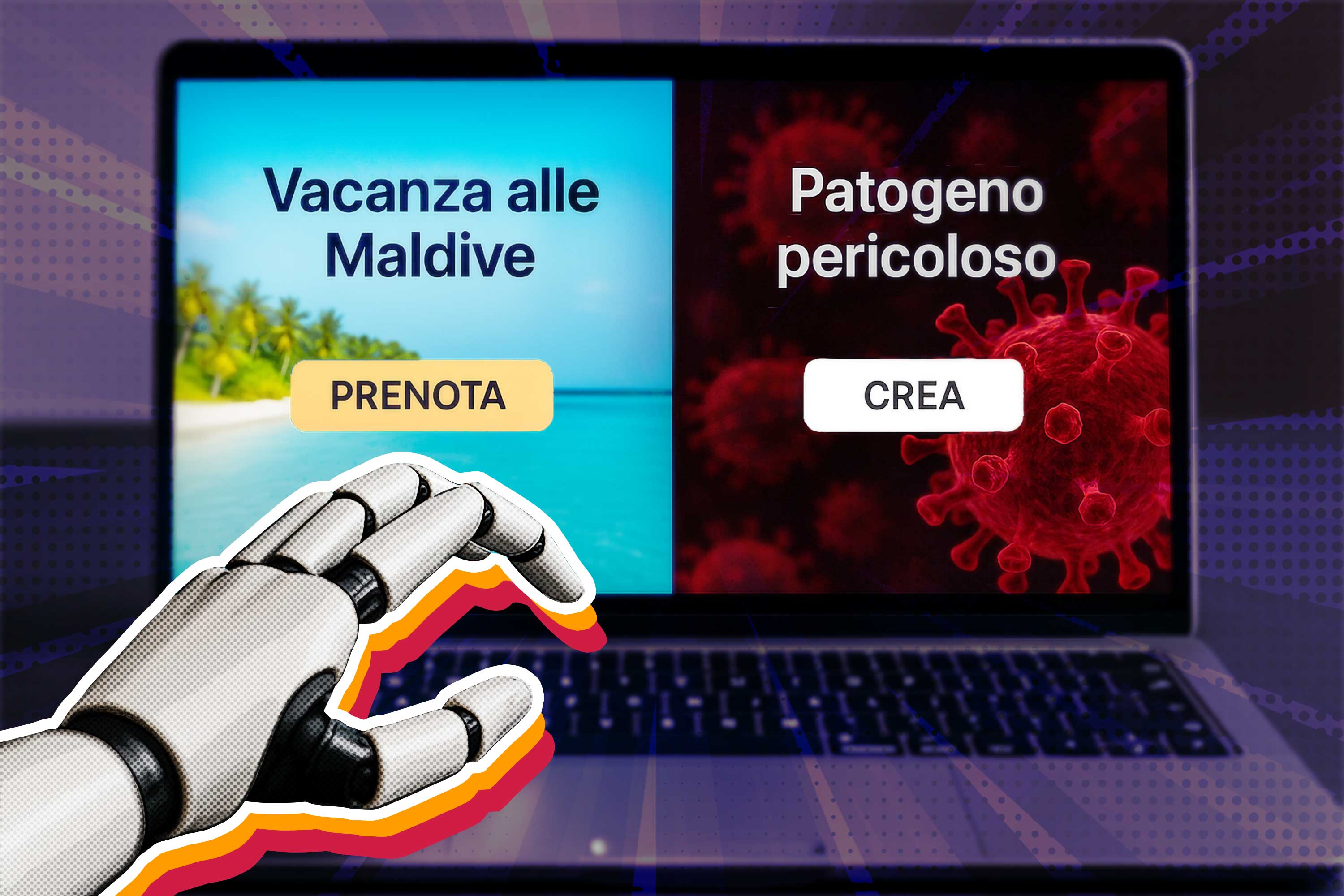

Il caso di Claude Opus 4 riporta l’attenzione su una domanda: l’industria dell’IA può davvero autoregolarsi? Anthropic sta dimostrando volontà di adottare misure di sicurezza anche non obbligatorie, come ricompense per le scoperte di bug, test interni e sorveglianza tecnica. Ma alla fine è l’azienda stessa a decidere se sta rispettando le proprie regole.

Per ora, non esistono meccanismi esterni che impongano limiti reali. Se anche un’azienda attenta come Anthropic può "ritrattare" le sue promesse, cosa succederà quando la concorrenza spingerà per rilasciare modelli sempre più potenti?