In due parole

OpenAI ha lanciato ChatGPT Agent, un assistente di intelligenza artificiale (IA) in grado di svolgere compiti complessi in autonomia. Per la prima volta nella storia dell’azienda, questo modello è stato classificato come ad alto rischio biologico. Ci sono anche preoccupazioni per il mercato del lavoro e per la sicurezza informatica.

ChatGPT Agent, un assistente super-autonomo

Il 17 luglio OpenAI ha annunciato ChatGPT Agent, una nuova funzione che spinge il chatbot oltre i suoi confini tradizionali. Non si limita più a generare testi: ora può eseguire azioni in autonomia, come navigare autonomamente sul web, gestire file, analizzare dati ed interagire con applicazioni di terze parti. È un salto notevole, che lo rende simile a un assistente digitale indipendente.

Tra le sue funzioni ci sono l’organizzazione di viaggi, la compilazione di moduli online, l’analisi di dati, la scrittura di report, la gestione di email, fino a operazioni più tecniche come l’uso di terminali di programmazione. Il modello è stato testato su vari compiti di alto livello e ha superato le versioni precedenti in test di matematica avanzata, modellazione finanziaria e analisi biologica.

Un allarme mai visto: OpenAI parla di rischio biologico

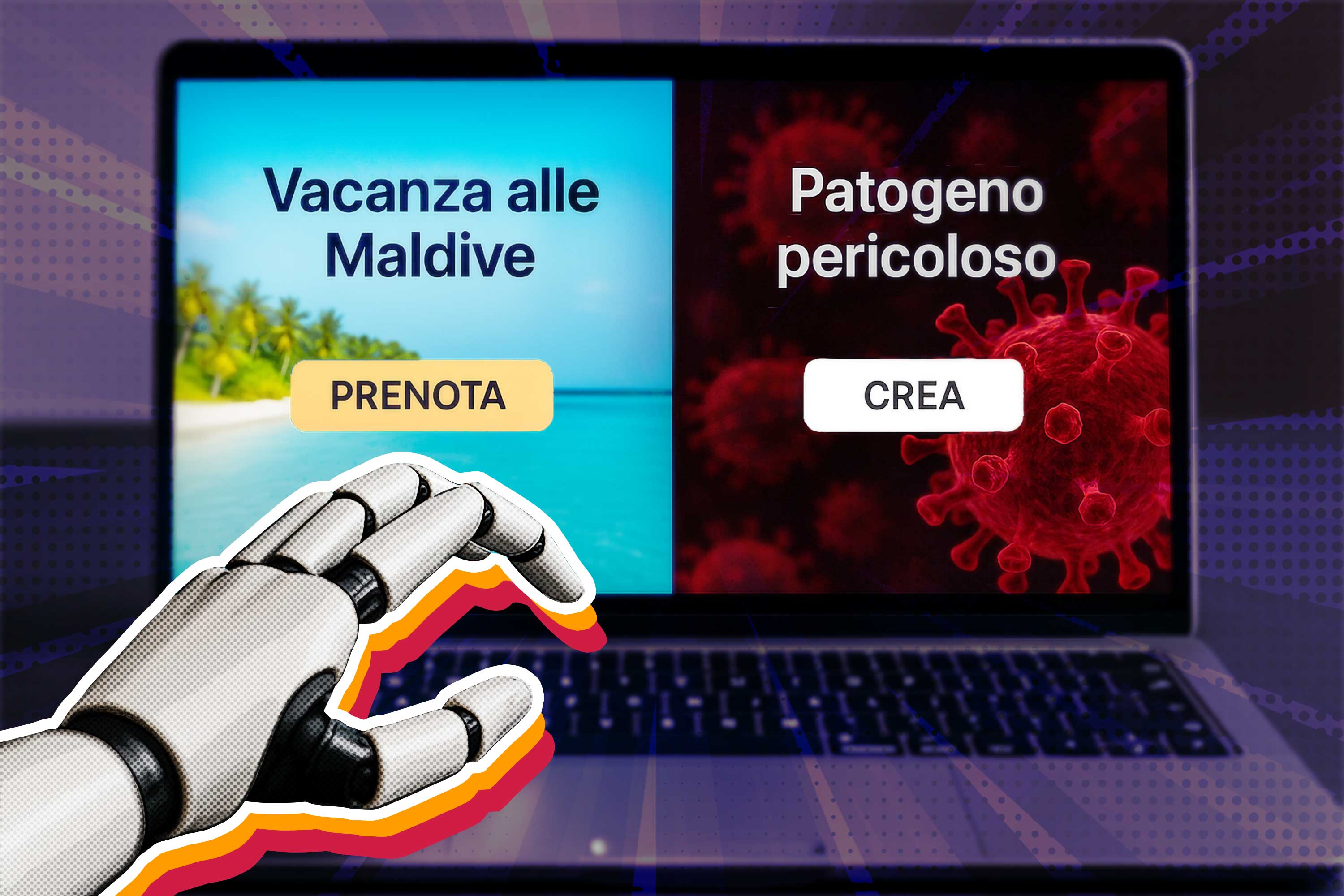

Nel presentare ChatGPT Agent, OpenAI ha anche introdotto una classificazione mai usata prima: "modello con capacità biologiche elevate". È la prima volta che l’azienda riconosce apertamente che un proprio sistema potrebbe aiutare anche un principiante a creare minacce biologiche reali.

ChatGPT Agent ha superato significativamente i modelli precedenti in test concreti di biologia e acquisizione di patogeni, confermando la sua capacità di semplificare la creazione di minacce biologiche.

Le difese messe in campo da OpenAI

OpenAI, consapevole delle implicazioni, afferma di aver introdotto il suo pacchetto di sicurezza più avanzato. Questo include:

- monitoraggio continuo delle attività a rischio biologico e chimico

- blocchi automatici per richieste sospette

- supervisione di esperti esterni e workshop di stress test

- collaborazione con l’UK AI Safety Institute, che ha individuato e aiutato a risolvere sette vulnerabilità prima del rilascio pubblico

Tutte queste misure dovrebbero prevenire l’uso malevolo del modello. Tuttavia, la natura stessa della tecnologia rende difficile un controllo totale.

Un virologo, inoltre, ha criticato il fatto che alcune semplici ricerche biologiche vengano bloccate, sostenendo che ci vorrebbe un accesso verificato per distinguere gli usi legittimi da quelli pericolosi.

Un’altra minaccia: la sostituzione del lavoro umano

Oltre ai rischi legati alla biosicurezza, ChatGPT Agent solleva interrogativi sul lavoro umano. Le sue capacità di automazione minano in particolare le mansioni d’ufficio più semplici e i ruoli entry-level.

Secondo i dati di Adzuna, nel Regno Unito le offerte di lavoro per ruoli junior sono calate di oltre il 30% dal 2022, quando ChatGPT è stato lanciato. Una coincidenza difficile da ignorare. Anche il governo britannico sta già usando l’IA per mansioni amministrative, riportando risparmi di tempo importanti.

Rischi aggiuntivi: privacy, dati e sicurezza informatica

L’autonomia di ChatGPT Agent introduce anche nuove vulnerabilità. Può accedere a dati personali attraverso siti e applicazioni collegate, il che crea potenziali problemi con regolamenti come il GDPR. C’è poi il rischio di attacchi via "prompt injection", ovvero istruzioni malevole nascoste in siti web che potrebbero manipolare il comportamento dell’agente. Poiché l'agente può “prendere iniziativa”, un attacco riuscito potrebbe avere un impatto maggiore, ad esempio condividendo dati privati.

OpenAI ha affermato di avere addestrato il sistema a resistere a questo tipo di attacchi e di disporre di sistemi di monitoraggio per identificarli e reagire. Tuttavia, il rischio zero non esiste, soprattutto quando l’agente ha il permesso di agire in autonomia.

Il controllo resta (almeno per ora) nelle mani dell’utente

Per limitare i danni, OpenAI ha previsto alcune barriere:

- l’agente chiede conferma prima di agire nel mondo reale (come fare acquisti)

- alcune azioni richiedono la supervisione diretta dell’utente

- compiti ad alto rischio vengono rifiutati automaticamente

- l’utente può eliminare i dati di navigazione con un clic

- le sessioni web sono isolate: ciò che succede lì non viene archiviato

Anche con queste precauzioni, la direzione è chiara: l’agente è pensato per fare sempre più da solo. E questo, inevitabilmente, comporta rischi.