In breve

Quasi metà del team di OpenAI dedicato alla sicurezza dell'intelligenza artificiale (IA) ha lasciato l'azienda negli ultimi mesi. Questo segnala un cambiamento verso la commercializzazione a scapito della sicurezza e solleva preoccupazioni sul futuro dell’IA responsabile.

OpenAI e la visione dell'AGI

OpenAI è ampiamente riconosciuta come una delle principali aziende nello sviluppo di intelligenza artificiale avanzata, nota per aver creato ChatGPT. Il suo obiettivo più ambizioso è lo sviluppo dell'intelligenza artificiale generale (AGI), un tipo di intelligenza autonoma in grado di svolgere attività complesse e in molti ambiti diversi, al pari degli umani.

Molti esperti hanno sottolineato fin da subito come i sistemi di AGI possano sfuggire al controllo umano e rappresentare una minaccia esistenziale per la nostra specie. In risposta a queste preoccupazioni, OpenAI si era impegnata a sviluppare l'AGI in modo sicuro e benefico per l'umanità, assumendo ricercatori nell’ambito della sicurezza.

La fuga dei ricercatori sulla sicurezza: numeri e motivazioni

Negli ultimi mesi, presso OpenAI si è verificato un significativo esodo di ricercatori nel campo della sicurezza dell'AGI. Secondo Daniel Kokotajlo, ex ricercatore di OpenAI, circa 14 dei 30 esperti di sicurezza AGI hanno lasciato l'azienda; tra questi, nomi illustri come Jan Hendrik Kirchner, Collin Burns e il co-fondatore John Schulman. Queste fughe si aggiungono alle dimissioni di alto profilo avvenute a maggio, quando il direttore scientifico Ilya Sutskever e il ricercatore Jan Leike hanno lasciato l'azienda, criticando il cambiamento di priorità di OpenAI verso prodotti più attraenti, a discapito della sicurezza. Il team "superalignment", incaricato di sviluppare soluzioni per il controllo della superintelligenza artificiale, è stato sciolto dopo queste dimissioni.

Daniel Kokotajlo, ex ricercatore di OpenAI, ha descritto una cultura aziendale in cambiamento, con un'enfasi crescente sulla commercializzazione a scapito della sicurezza. Kokotajlo ha lasciato l'azienda nel 2024 dopo aver notato una graduale erosione dell’enfasi sulla sicurezza, nonché un "effetto intimidatorio" sulla pubblicazione di studi sui rischi dell'AGI e un'influenza crescente dei reparti di comunicazione e lobby. A suo avviso, molti dei suoi ex colleghi hanno deciso di abbandonare a causa della percezione che OpenAI stia avvicinandosi allo sviluppo dell'AGI senza essere preparata a gestirne le conseguenze.

Dalla sicurezza ai profitti: una trasformazione aziendale

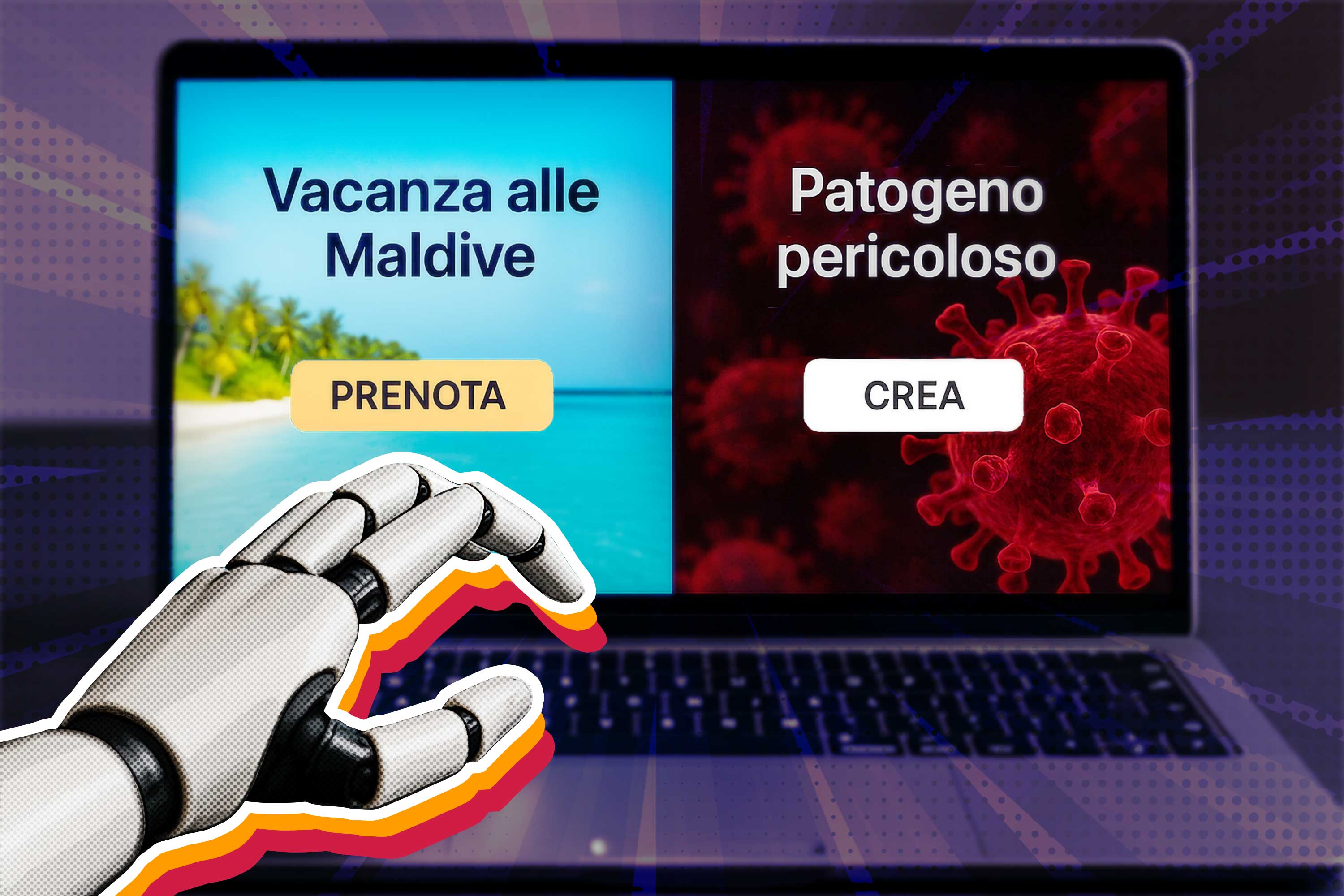

Negli ultimi mesi, OpenAI ha assunto figure di spicco del settore finanziario e commerciale, come Sarah Friar come CFO e Kevin Weil come Chief Product Officer. Queste assunzioni evidenziano un cambiamento di rotta verso la redditività e lo sviluppo di prodotti, piuttosto che sulla sicurezza e la ricerca a lungo termine. Kokotajlo e altri hanno espresso preoccupazioni sul fatto che le motivazioni di profitto possano spingere l'azienda a prendere decisioni rischiose riguardo allo sviluppo dell'AGI, che potrebbero compromettere la sicurezza globale.

Nonostante la fuga di molti ricercatori, alcuni continuano a lavorare su progetti di sicurezza all'interno di OpenAI. Dopo lo scioglimento del team "superalignment", alcuni membri sono stati riassegnati ad altri team. La creazione di un nuovo comitato per la sicurezza e la nomina di Zico Kolter, un professore specializzato in sicurezza dell'IA, al consiglio di amministrazione di OpenAI, sono sembrati passi importanti per mantenere l'attenzione sulla sicurezza. Tuttavia, Kokotajlo ha avvertito del rischio di un "effetto gregge" all'interno dell'azienda: il clima dominante di corsa allo sviluppo dell'AGI potrebbe influenzare negativamente la valutazione dei rischi.

Un futuro incerto per la sicurezza dell'IA

La riduzione dell’attenzione verso la sicurezza all'interno di OpenAI è un segnale preoccupante in un momento in cui le grandi aziende di tech competono ferocemente per sviluppare l'AGI. Questo cambiamento solleva interrogativi sulla capacità dell'azienda di mantenere il suo impegno originario per uno sviluppo sicuro dell'AGI e indica potenziali pericoli per l'intera umanità se la sicurezza continua a essere messa in secondo piano rispetto alla redditività.