In breve

OpenAI ha deciso di non implementare un sistema per riconoscere i testi generati da ChatGPT per timore di perdere una parte significativa dei suoi utenti.

Introduzione

In un'era in cui l'intelligenza artificiale sta ridefinendo i confini della creatività e della produzione di contenuti, OpenAI, l’azienda madre di ChatGPT, si trova al centro di un dibattito cruciale. L'azienda ha recentemente preso una decisione che solleva interrogativi sul delicato equilibrio tra innovazione, responsabilità etica e interessi commerciali.

Cos’è successo

OpenAI aveva pronto da un anno un sistema di watermarking per i testi generati da ChatGPT, una tecnologia che permette di rilevare se un testo è stato scritto dal celebre assistente IA. Questo sistema, basato su un pattern statistico creato durante la generazione del testo, è risultato molto efficace e resistente a tentativi di parafrasi. Tuttavia, l'azienda ha deciso di non rilasciarlo.

Un sondaggio commissionato da OpenAI ha rivelato che quasi il 30% degli utenti di ChatGPT utilizzerebbe meno il software se fosse presente il watermarking. Questa statistica ha evidentemente pesato sulla decisione finale dell'azienda, nonostante ci sia un buon supporto interno all'idea di uno strumento di rilevamento dell'IA. La società ha annunciato che sta esplorando altre tecniche meno controverse, come l'inserimento di metadati nei testi generati, ma è ancora troppo presto per sapere quanto saranno efficaci.

Cos’è esattamente il watermark?

Il concetto di watermarking (traducibile in italiano come “filigrana”) per i modelli di IA si basa su principi di crittografia e statistica. In sintesi, il sistema modifica leggermente il processo di generazione del testo, influenzando la scelta delle parole e persino della punteggiatura in modo impercettibile all'occhio umano, ma rilevabile attraverso analisi statistiche.

Il processo si basa sulla tokenizzazione, un passaggio fondamentale nell'elaborazione del linguaggio da parte dell’IA. I token possono essere parole intere, parti di parole o segni di punteggiatura. Il modello IA genera una distribuzione di probabilità per il token successivo in un testo basandosi sui token precedenti. Il watermarking introduce una leggera distorsione in questa distribuzione, senza influenzare la qualità del testo. Si crea però un pattern che sembra casuale, ma che può essere decodificato solo da chi conosce la chiave crittografica.

Il modo più diretto per cercare di bypassare questo sistema è parafrasare i testi, a mano oppure con l’aiuto di altri modelli di IA.

Questa tecnologia avrebbe potuto avere applicazioni significative, in particolare nel campo dell'istruzione, aiutando gli insegnanti a individuare i compiti generati dall'IA, e nella lotta alla disinformazione, permettendo di identificare contenuti artificiali diffusi online.

Implicazioni

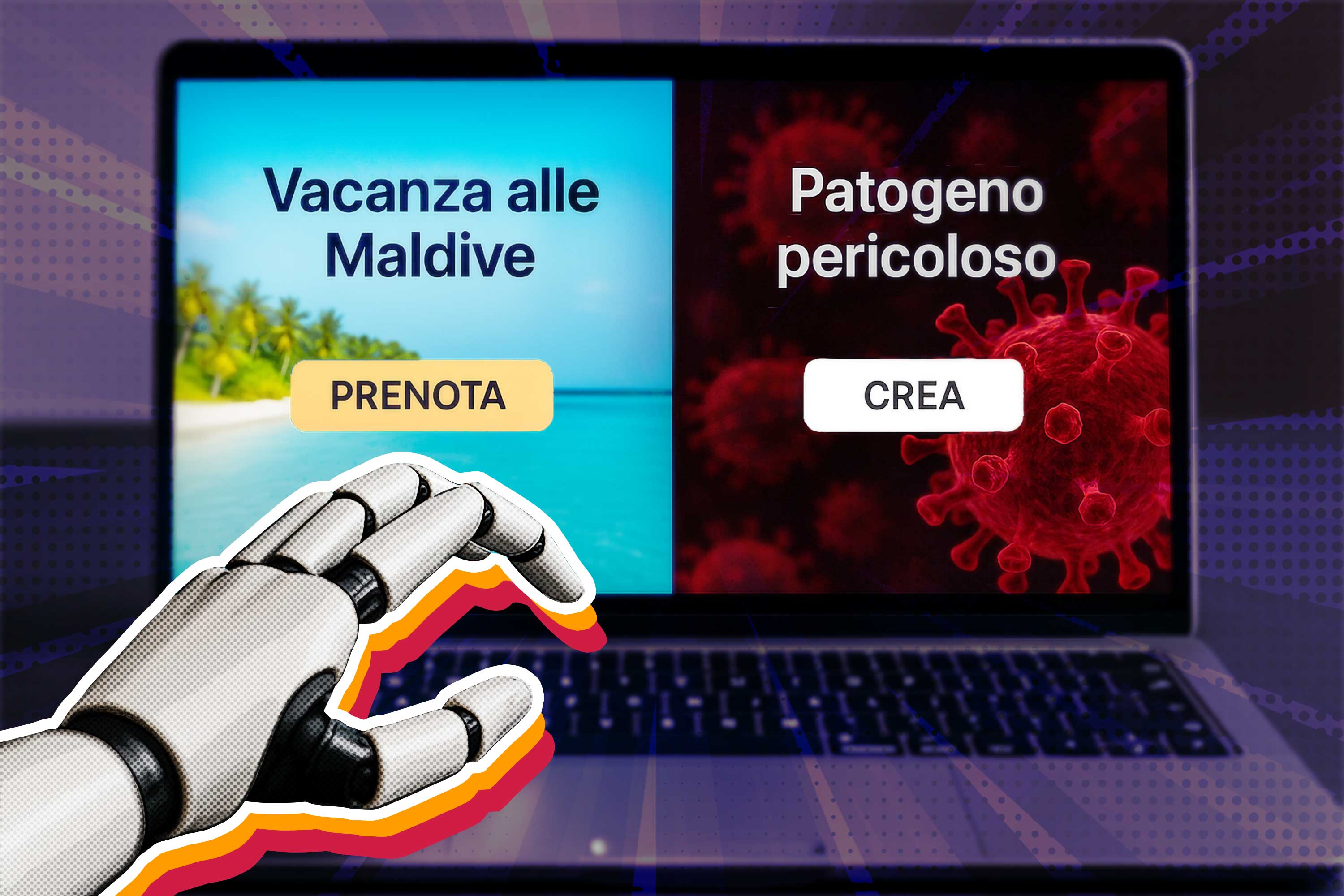

La decisione di OpenAI di non implementare il watermarking solleva preoccupazioni significative sulla direzione che sta prendendo lo sviluppo dell'IA. Mentre l'azienda sembra privilegiare la crescita degli utenti e, presumibilmente, la redditività, si perde un'ottima opportunità per aumentare la trasparenza e la responsabilità nell'uso dell'IA.

Da un lato, questa scelta potrebbe accelerare l'adozione e l'uso di strumenti di IA generativa, portando potenzialmente a innovazioni e progressi in vari campi. Dall'altro, potrebbe complicare gli sforzi per gestire le sfide etiche poste dall'IA, come la diffusione di disinformazione o il plagio accademico. Inoltre, scegliendo di non implementare uno strumento che avrebbe potuto aumentare la trasparenza, OpenAI rischia di alimentare scetticismo e preoccupazioni sulla responsabilità delle aziende di IA.