In breve

Il rapporto sullo “State of AI 2024” evidenzia un passaggio dall'attenzione per la sicurezza dell'IA all'innovazione, con aziende che investono in modelli più potenti, crescenti vulnerabilità e abusi degli strumenti di IA accessibili. Nel frattempo nascono iniziative governative di regolamentazione, anche se la cooperazione internazionale rimane limitata.

Il rapporto “State of AI 2024”

Il rapporto “State of AI” è una pubblicazione annuale prodotta dall’investitore Nathan Benaich e dal team di Air Street Capital che analizza gli sviluppi più rilevanti nel campo dell'intelligenza artificiale (IA). Quali trend sulla sicurezza dell'IA sono stati individuati nel rapporto del 2024? Ecco i cinque punti principali.

1. Le aziende puntano sull’innovazione invece che sulla sicurezza

Nel corso del 2024 il panorama della ricerca sull'IA ha subito un cambio di rotta: si sta facendo sempre meno attenzione ai rischi dell’IA, e ci si concentra invece sull’accelerare lo sviluppo e la distribuzione di questa tecnologia. Le principali aziende che sviluppano modelli avanzati, come OpenAI e Google, che in precedenza esprimevano preoccupazioni sui pericoli dell'IA avanzata, stanno ora promuovendo attivamente l'uso diffuso dei loro prodotti e investendo risorse per creare modelli sempre più potenti. Questo cambiamento è probabilmente motivato dalle pressioni commerciali e dalla necessità di guadagnare quote di mercato.

2. Nuove vulnerabilità

Il rapporto dedica molta attenzione alla pratica del "jailbreaking", che consiste nell'aggirare le misure di sicurezza implementate dagli sviluppatori nei sistemi di IA. I ricercatori hanno scoperto numerose vulnerabilità nei modelli di IA, che permettono di generare output dannosi o rivelare informazioni sensibili.

Inoltre, la ricerca indica che sono possibili attacchi più insidiosi, come gli "agenti dormienti": si tratta di large language models che hanno un comportamento sicuro subito dopo il rilascio, ma che diventano maligni dopo qualche tempo.

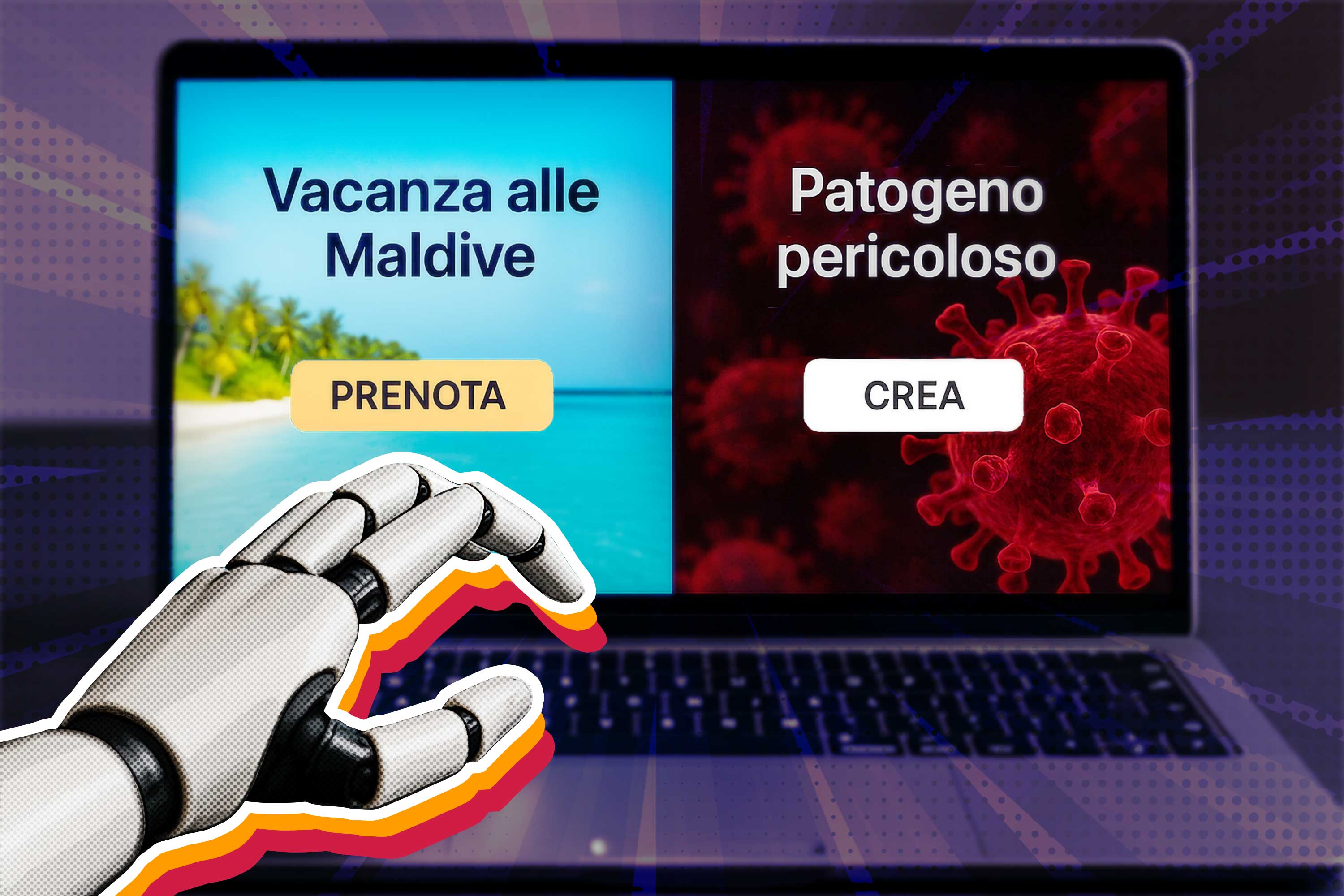

3. Uso improprio degli strumenti di IA facilmente accessibili

Molti casi di abuso dell'IA derivano dall'uso improprio di strumenti facilmente accessibili: per esempio, usare i generatori di immagini IA per creare deepfake, oppure usare i large language models per creare contenuti dannosi e diffondere disinformazione. Questi problemi mostrano la necessità di discussioni a livello sociale e di interventi politici per affrontare i rischi associati agli strumenti di IA ampiamente accessibili.

4. Maggiore attenzione dei governi alla sicurezza e alla regolamentazione

A seguito delle discussioni sulla sicurezza dell'IA nel 2023, i governi di tutto il mondo stanno prendendo provvedimenti per stabilire legislazioni e istituzioni dedicate alla sicurezza dell'IA.

- Il Regno Unito ha creato il primo istituto per la sicurezza dell'IA per valutare i modelli avanzati, istituire un laboratorio statale per la ricerca sulla sicurezza e coordinarsi con partner internazionali.

- Allo stesso modo, gli Stati Uniti hanno lanciato il proprio istituto per la sicurezza dell'IA e iniziative focalizzate sulla valutazione dei rischi dell'IA per le infrastrutture nazionali critiche.

- In Europa è passato l’AI Act, il primo quadro legislativo al mondo per l’intelligenza artificiale. La sua applicazione avverrà per gradi, con il divieto su “rischi inaccettabili” (per esempio l’inganno o i sistemi di punteggio sociale come quello cinese) in arrivo a febbraio 2025.

Questi sforzi dimostrano una crescente consapevolezza da parte dei governi della necessità di misure per mitigare i potenziali rischi associati all'IA.

5. Collaborazione internazionale

Il rapporto sottolinea la necessità di collaborazione internazionale e di governance per affrontare le sfide globali poste dall'IA. Sebbene siano stati fatti i primi passi con iniziative come la Dichiarazione di Bletchley e il Summit sulla sicurezza dell'IA di Seoul, questi sforzi rimangono per lo più di alto livello e non vincolanti. Ci sono anche segnali che non tutti i paesi siano ugualmente impegnati ad affrontare le preoccupazioni sulla sicurezza dell'IA, con alcuni che danno priorità ai benefici economici rispetto ai potenziali rischi.