In breve

La tecnica della stable diffusion, usata per generare contenuti tramite l’intelligenza artificiale, aveva avuto successo solo nel campo delle immagini e dei video. Un gruppo di ricercatori è finalmente riuscito ad adattarla anche alla generazione di testo, ottenendo prestazioni simili a quelle di GPT-2.

Il panorama dell’IA generativa

Il dominio dei modelli di linguaggio autoregressivi

Fino ad oggi, la generazione di linguaggio naturale con l’intelligenza artificiale è stata dominata dai modelli detti autoregressivi. Questi modelli, tra cui il più noto è sicuramente ChatGPT, prevedono nuovo testo parola per parola basandosi sulle parole precedenti. Nonostante gli straordinari risultati ottenuti, questi modelli sono piuttosto instabili e offrono poco controllo sul processo di generazione, richiedendo spesso complesse tecniche di adattamento per mantenere la coerenza e la qualità del testo generato.

Il successo della stable diffusion nella generazione di immagini

I modelli di stable diffusion sono invece noti per la loro capacità di generare immagini e video di ottima qualità. Questi modelli funzionano aggiungendo gradualmente rumore ai dati e poi imparando a invertire questo processo. Così, possono generare immagini straordinarie partendo da immagini contenenti solo rumore, “ripulendole” a mano a mano.

Stable diffusion per il linguaggio: una nuova frontiera

Applicare la tecnica della stable diffusion alla generazione di testo offrirebbe un approccio più flessibile e preciso, perché si potrebbero generare contenuti partendo da qualsiasi punto del testo, a differenza dei modelli autoregressivi. Tuttavia, finora i ricercatori non erano mai riusciti a generare testo di buona qualità con questa tecnica.

Un team di ricercatori dell’università di Stanford sta facendo passi avanti per superare queste difficoltà, con un articolo che si è aggiudicato il premio di miglior articolo all’International Conference on Machine Learning di luglio 2024. Il loro approccio, noto come "Score Entropy Discrete Diffusion" (SEDD), estende a dati discreti (come le parole di un testo) tecniche che funzionavano solo su dati continui (come i colori di un pixel di un’immagine).

I risultati sperimentali mostrano che SEDD non solo supera i precedenti modelli di stable diffusion, ma riesce anche a competere con GPT-2 in termini di qualità e coerenza del testo. Poiché SEDD utilizza un numero simile di parametri rispetto a GPT-2, questo dimostra che la stable diffusion potrebbe diventare una valida alternativa ai modelli autoregressivi.

Prospettive future

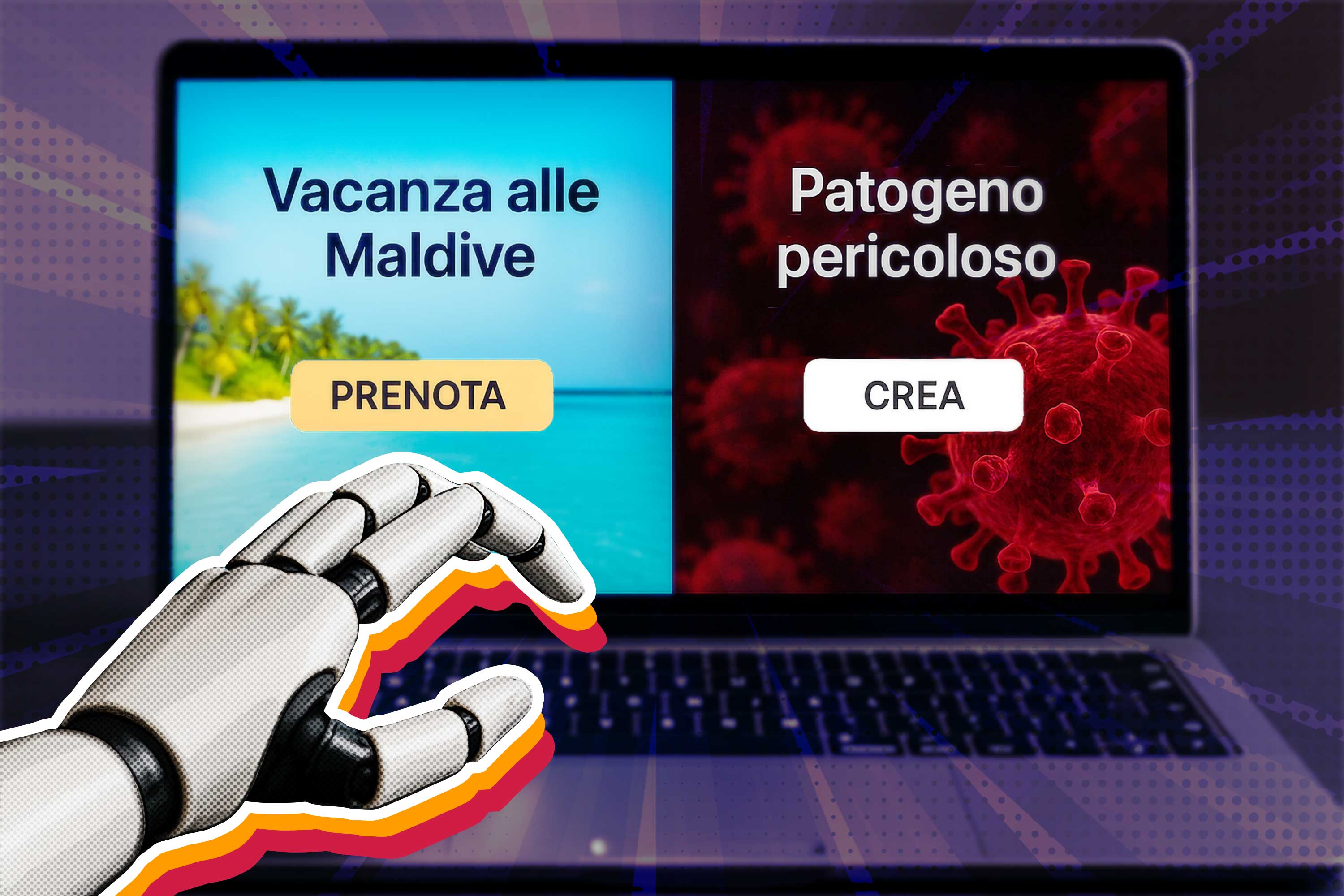

Se, con ulteriori ricerche, i modelli di stable diffusion continuassero a migliorare, questo nuovo paradigma potrebbe affiancarsi a quello autoregressivo. La maggiore flessibilità della stable diffusion potrebbe rendere più facile allineare i modelli di linguaggio ai valori degli esseri umani. Al contempo, la capacità di generare testo sempre più convincente e controllabile solleva questioni sulla disinformazione e sull'uso improprio di queste tecnologie.